너무 춥고 힘들었지만, 잘 나왔군요

bassist.homerecz.com

너무 춥고 힘들었지만, 잘 나왔군요

덩케르크 두번째 보고서 이제야 좀 이해가 간다.

-젊은이들-

나라를 위해 희망도 버리고 꿈도 버리고

사지에 몰려서 죽어가는 젊은세대는

우리의 20-30대를 보는것 같고

-기성세대-

자신의 아이가 죽어가며,자신의 배를 기꺼이 몰아 그 젊은 세대를 구하러 덩케르크 해변에 배를 몰고 가는 부모님 기성 세대들

-전문가-

그리고 전투기한대를 몰며 우리의 젊은이들을 죽이고 위협하는 독일 폭격기를 처리하는 공군조종사 열심히 싸우고 전적을 올렸지만 결국엔 덩케르크 해안에 불시착해 독일군에 잡혀간다

-고위직-

마지막까지 당케르크 항구에 남아 남은 사람들까지 구출해내려는 함장

-대표자-

신문에 겨우 말 몇마디 하며 우리가 덩케르크 철수작전을 이긴거라고 정신승리하는 처칠 수상-

지금의 우리나라에 어떤게 비슷하고 어떤게 다른걸까?

지금 우리에게

저런 젊은이와 대표자는 있지만

저런 기성세대와 저런 함장 저런 전문가는 어디있는가

보통 저가형 오디오 인터페이스들은 다이렉트 모니터링을 버튼식이나 노브식으로, 아날로그의 방식으로 해주게 됩니다.

이런 오디오인터페이스들의 경우에는 다이렉트 모니터링을 DSP 로 하지 않고 그냥 순수한 아날로그 루팅으로 하다보니, DSP 칩이 아예 없어서, DSP FX 도 당연히 없습니다. DSP 칩이 있는 경우는 DSP mixer 로 다이렉트 모니터링 뿐만 아니라 추가로 리버브 같은 DSP FX 가 있어서 녹음하면서 모니터링시 리버브 효과도 줄 수 있는 경우가 있습니다.

솔직히 노래를 녹음하거나 할떄 모니터링 되는 자기 소리에 리버브가 촉촉히 묻어있으면 더욱 감성을 터치 하여 노래가 더 잘되는 부분도 무시하지 못합니다.

그래서 녹음시에 이렉트 모니터링을 포기하고 그냥 소프트웨어 모니터링을 통해서 레이턴시가 있더라도, 리버브를 플러그인으로 걸고 모니터링을 하기도 합니다. 하지만 이 경우 제로레이턴시로 모니터링이 안된다는 단점이 크게 있습니다.

하지만 아날로그식 다이렉트 모니터링(버튼식,노브식) 이라 DSP FX 가 없는 경우에 이것을 전혀 못하는 것은 아닙니다.

큐베이스를 예시로 설명해보겠습니다.

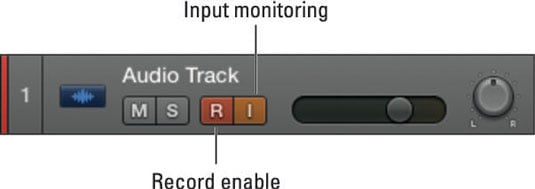

우선 아래와 같이 오디오트랙을 하나 만듭니다.

이렇게 만든 트랙은 보컬 녹음을 하기 위해서 UR12 오디오 인터페이스(버튼식, DSP FX 없음) 의 1번 인풋을 입력으로 설정합니다.

그 다음 FX send 채널을 만듭니다.

다이렉트 모니터링을 사용할것이기 때문에 보통은 녹음할 트랙의 input monitor 버튼을 켜지 않고 다이렉트 모니터링 버튼을 눌러서 자신의 목소리를 녹음하게 되는데요,

여기서는 일부러 해당 트랙의 출력을 No BUS 로 설정하고 Input monitor 버튼을 눌러서 사용합니다.

다시말해서 녹음하는 소리의 원래 소리는 오디오 인터페이스의 다이렉트 모니터링 기능을 이용해서 제로레이턴시로 모니터링하고, 리버브 이팩터만 내부에서 SEND FX 를 이용해서 걸어서 잔향만 소리가 나오도록 하게 됩니다.

이렇게 사용하면, DSP FX 가 없는 오디오 인터페이스로도 얼마든지 리버브가 걸린소리로 모니터링하면서 녹음이 가능합니다.

포커스라이트사의 제품들중에는 DSP Mixer 는 있지만, DSP FX 는 없는 경우가 있고 (클라렛, 레드넷 등) 또한 RME 제품중에서도 Total mix FX 가 아닌 일반 Total mix 의 경우에는 리버브가 DSP Mixer 에서 빠져있기도 합니다. 이런 오디오 인터페이스들에서도 이것을 응용하면, CUE 모니터 등에도 이렇게 설정하여 사용할 수 있습니다.

큐베이스나 로직 등의 DAW 를 통한 보컬이나, 어커스틱 악기 녹음시, 지금 연주하거나 노래 하는 것을 헤드폰으로 듣기 위한 모니터링 방법에는 여러가지가 있지만, 크게 다음의 두가지가 있다.

그렇다면, 네이티브 모니터링을 하지 말아야 하는 이유는 무엇인가, 네이티브 모니터링할때 보컬 트랙에 걸어놓은 컴프레서나 이큐 등이 걸린채로 모니터링되므로, 그런 모니터링을 하면 좋겠다고 다들 생각하지만, 네이티브 모니터링에는 큰 단점이 있다. 그것은 바로 레이턴시 인데,

오디오 인터페이스 성능이 아주 좋아서 10ms 정도로 레이턴시를 줄였다고 가정해보자.

탬포 120BPM 의 곡에서 1분에 120개의 4분음표가 있음을 의미 한다. 따라서, 1개의 4분음표는 0.5초 의 길이를 가지고 있고, 8분음표의 경우는 0.25초. 16분 음표의 경우는 0.125 초의 길이이다. 여기서 레이턴시 10ms 를 생각해보자. ms 는 1/1000초의 단위로, 10ms 는 0.010초의 길이이다.

즉 16분음표 0.125 초/ 10ms 0.01 초

10ms 는 대략 16분음표의 1/10의 길이이다.

따라서 10ms 의 레이턴시가 있는 네이티브 모니터링시, 16분음표연주의 정확성에서 이미 10%의 오차를 가지고 가는것이다. 또한 8분음표에서는 5%에 해당한다.

이것은 랩과 같이 리듬을 중시하는 보컬 뿐만 아니라 , 일반적인 보컬에도 녹음시에 큰 지장을 초래 할 수 있다. 악기 연주에는 치명적이다.

결국 이러한 레이턴시가 아무리 짧게 해서 10ms 라 할지라도, 결국 실제 녹음시에는 큰 방해요소가 된다.

주변에 흔히 , 기타나 베이스를 오디오 인터페이스에 연결하고, 기타앰프나 베이스 앰프시뮬레이터를 플러그인으로 걸어서 사용하는 경우를 볼 수 있는데, 이것을 오랫동안 인지하지 못한 채로 계속 한다면, 이것이 몸에 익숙해져서, 당신의 박자 감각은 총체적으로 무너질 수 있다. 프로 보컬이나, 프로 연주자로써의 인생을 포기해야할 수도 있다.

따라서 녹음시 모니터링은 네이티브 모니터링보단 다이렉트 모니터링(하드웨어 모니터링) 을 사용해야한다

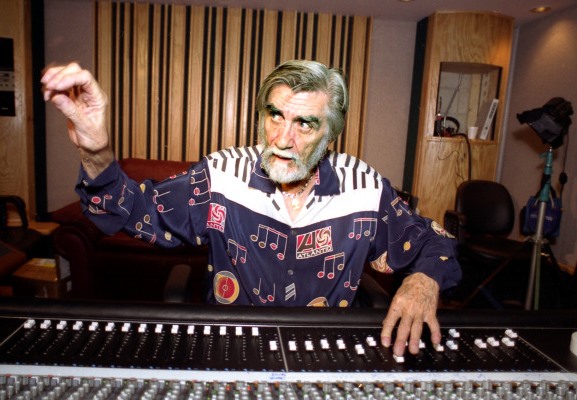

Tom dowd

페이더가 개발되기 이전의 오디오 믹싱 콘솔들은 위 사진처럼 커다란 노브 형태의 볼륨 조절 장치를 가지고 있었다.

하지만 Tom dowd 라는 한 레코딩 엔지니어는 자신이 피아노를 연주하는것처럼 모든 악기의 밸런스를 컨트롤 하고 싶었고, 그 아이디어를 통해서 Fader 를 개발한다.

그의 아이디어는 매우 통했고, 그 이후로 대부분의 오디오 믹싱 콘솔은 피아노 건반과도 같은 Fader 를 사용하여 볼륨을 조절하게 되었다.

그의 레코딩중 Giant step. John coltrane

악기의 넥과 브릿지를 통해서 줄 높이를 조정해야하는 경우

국내 인터넷 커뮤니티들 중심으로 잘못된 정보가 널리 퍼져있는걸로 보인다.

“넥의 트러스로드는 함부로 건드는게 아니다.” 라는 잘못된 정보

줄높이를 조정하기 위해서 넥은 함부로 건드는게 아니니까 브릿지 새들을 높이거나 낮추라는 잘못된 정보가 몇십년동안 국내 커뮤니티 중심으로 퍼져있다.

줄높이를 조정하는 방법은 다음과 같다.

1 기타나 베이스의 첫프렛과 마지막 프렛을 눌러서 스트링과 넥을 붙이면 넥의 릴리프 정도를 알수 있다 줄과 평행하거나 약간은 릴리프가 있는 넥의 정도를 맞추기 위해서 트러스로드를 사용해서 맞춘다.

2. 그 상태에서 이제 브릿지 새들을 조정하여 실제 연주시 편한 줄 높이를 만들고 동시에 새들을 앞뒤로 조정하여 피치와 인토네이션을 잡는다.

3 이렇게 하면 스트링의 장력이 재조정 되므로 넥의 릴리프를 다시 봐야한다 1번으로 반복 .

4 다시 조정된 넥의 릴리프를 가지고 다시 새들의 인토네이션과 피치를 본다

5 이렇게 반복해서 맞춘 상태가 보통 세팅이 완성된거고 악기의 공장 출하 default 셋팅도 이렇게 맞추는걸로 알고 있다. 또한 숙련자일수록 금방 끝나며 악기가 넥이 튼튼한 악기 일수록 금방 끝난다

특히 바디와 낵을 분리해야 넥의 릴리프 조절이 가능한 펜더올드 기타들의 경우 넥의 릴리프 제조정이 필요 없을 정도로 넥이 튼튼해서 한번에 끝나는 경우가 많다 ( 바디와 넥을 분리해야해서 일반적으로 보기엔 조정이 힘들것 같지만 사실 넥이 튼튼하기 때문에 더 쉽다.한번에 끝나기 때문)

이제 그 다음이 제일 중요한데 이제 이후에 악기를 가지고 사용하다가 온도나 날씨 습도에 의해 줄 높이가 변경되면 당신은 무엇을 만질 것인가?

브릿지새들 높이? 넥의 릴리프?

.

.

.

.

.

멍청하게도 많은 인터넷 커뮤니티들이 새들높이를 조정하라고 한다는거다

절대 브릿지 새들 높이는 날씨나 온도에 의해 변한적이 없는데도 말이다.

브릿지는 함부로 건드는게 아니다 피치와 인토네이션이 다 날라간다

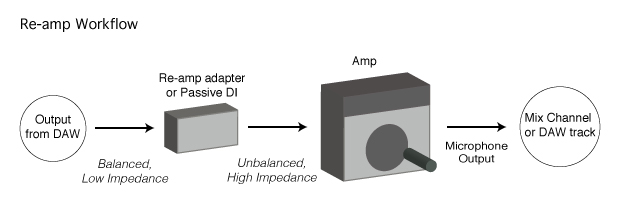

기타 리앰프 테크닉은, DI 나 , 오디오 인터페이스의 Hi-Z 입력을 통해서 녹음한 기타의 생톤 소리를 , 오디오 인터페이스의 아웃풋으로 다시 출력해서 다시 기타 앰프로 입력시키고, 앰프를 다시 마이킹 하여 소리를 녹음하는것을 말한다.

일단 첫번째로 기타를 녹음할 때에, 앰프 마이킹 톤을 녹음 받는것에 추가로 instrument DI 등을 사용하여, 앰프를 거치지 않은 생톤을 따로 녹음 해 놓아야 한다.

이 “생톤”은 앰프도 거치지 않았고, 마이킹도 거치지 않은 순수한 소스 이기 때문에 소리가 많이 어색하겠지만, 보통 이 상태의 소스에 앰프 시뮬레이터 플러그인등을 사용하여, 다양한 앰프의 톤을 얻는것으로 많이 사용한다.

하지만 아무래도, 앰프 시뮬레이터가 발전을 많이 하고 있지만, 실제 앰프의 늬앙스가 그리울 때가 있거나, 특별한 앰프의 톤을 사용하고 싶을 때가 있다.특히 앰프 시뮬레이터들이 IR 방식을 사용해서 캐비넷의 질감을 재현하고 있지만 Speaker의 Excursion 에 따른 부하 변동의 Nonlinear 한 반응을 재현하지는 못하고 있는게 사실이다.

그래서 녹음 받아놓은 이 기타의 생톤을 다시 출력시켜서 앰프로 넣어서 재생시켜서 , 다시 마이킹등을 통해 녹음 받는것을 Reamp 라고 한다.

단, 우리가 기타의 생톤을 녹음할때 DI 를 사용했듯이, 이 녹음받은 소스를 다시 출력시키면, Line level 이기 때문에 , 이것을 다시 instrument level 로 변경시켜서 앰프에 입력시켜야 할 필요가 있다. 그냥 출력시켜서 앰프에 입력시키면 앰프의 입력보다 너무 전압이 높은 시그널이 들어와서 제대로 사용하기가 힘들기 때문이다.

그럴때 그러한 Line level 시그널을 다시 앰프에 입력시키기에 적당한 instrument level 로 변경시켜주는 것이 바로 이 Reamp 라는 장비다.

이 reamp 를 사용하여 위와 같이 이미 녹음된 기타의 생톤을 다시 앰프로 입력시켜서 마이킹을 다시 하여 녹음 받을수 있다.

앰프를 통해 마이킹을 하여 녹음된 소스가 맘에 들지 않아서 앰프의 셋팅을 변경한다던지, 마이크의 위치를 바꿔본다던지 , 다른 앰프로 교체해서 해본다던지 여러가지의 어플리케이션이 있을수 있고 , 많은 가능성을 열어줄 수 있다.

그러나,

이 Reamping 테크닉에는 넘어야할 산이 하나 존재한다. 바로 기타에서 출력된 기타의 오리지널 생톤과, 그것을 녹음한후, 다시 출력되어서 reamp 를 통해서 나오는 기타의 reamp 생톤이 일치 하지 않을 수 있기 때문이다.

실제로 Reamp 를 해보려고 이러한 reamp 장치를 구해서, 시도하면, 녹음할 당시의 기타앰프의 게인 값과, 다시 reamp 하여 입력시킨 소리의 앰프의 게인값이 달라서, (오리지널 생톤과, reamp 된 생톤의 시그널이 차이가 있어서) 앰프 자체의 오버드라이브가 더 걸린다던지, 아니면 반대로 , 앰프의 소리가 힘이 없게 들어온다던지 하는 문제가 생길 수 있다.

이 부분에서 많은 레코딩 엔지니어들이 당황한다.

이것을 해결하는 방법은, Calibration 이다.

즉, 기타를 그냥 앰프에 연결했을때 앰프에 입력되는 시그널과, 그 연주를 그대로 녹음하여, Reamp 로 출력하여 앰프에 연결했을때 앰프에 입력되는 시그널, 이 두가지를 정확하기 일치시키는 작업이 필요하다.

Calibration 하지 않으면, Reamping 해도 아무의미가 없다.

이렇게 Calibration 을 해놓으면, 최초 DI 를 통해서, 앰프로 마이킹 되어 나오는 소리와, 나중에 DAW 에 녹음된 생톤을 reamp 로 다시 앰프로 마이킹해서 나오는 소리가 99% 일치 하게 만들 수 있다.

추가로

요즘 나오는 위와 같은 제품은 Reamp output 을 지원하기도 하는데, 이 output 으로 나오는 신호는 입력으로 들어오는 신호과 100% 동일한 신호를 내보내도록, Calibration 이 되어있다고 광고하고 있다. 실제로 동일한지는 사용해 보지 않아서, 사용해보시는 분들께서 알려주셨으면 좋겠다.

오랜만에 해당 카테고리에 글을 적는다.

최근 재즈신 등에서 DPA4099를 콘트라베이스의 픽업 대용으로 사용하는 경향이 종종 보이고 있는데, 이것에 대한 장단점을 좀 써볼까한다.

DPA4099는 그 톤자체로 마이크 이기 때문에 매우 사실적인 소리를 내어줄 수 있다.

단 주의할 점이 있는데,

첫번째는, 마이크 이기 때문에, 주변 악기 소리가 그대로 전부 수음될 가능성이 높다. 문제는 재즈 연주자들이 사용하는 악기들이 클래식 연주자들의 악기와는 달리 대부분 소리가 크지 않은 경향이 있는데, 비용적인 문제이기도 하겠지만. 이런경우 주변에 드럼이라도 있으면 드럼소리가 그대로 DPA4099 로 들어오는소리가 자체의 콘트라베이스의 볼륨보다 커버리면, 이것이 상당한 문제가 되버린다. 악기자체의 볼륨이 큰 악기일경우에만 효과가 좋다고 볼 수 있다. 주변에 스테이지 모니터 스피커가 있어도 큰 문제가 될 수 있다.

두번째는, 48V 팬텀파워를 필요로하고 프리앰프의 성능에따라 매우 큰 차이가 난다는 사실이다. 연주자는 당연히 팬텀파워를 공급해줄 프리앰프를 같이 셋트로 들고 다녀야 한다는거다.

필자는 최근 여러건의 라이브 레코딩에서 이러한 DPA4099 로 벌어지는 최악의 상황을 여러번 경험을 직접했다.

키쓰자렛 트리오의 콘서트에서 게리피콕의 경우 GK 앰프와 리얼리스트 픽업의 조화로 괜찮은 재즈 베이스의 톤을 들려주고 있고, 그 덕에 더욱 깔끔한 트리오의 사운드를 완성할 수 있었다고 생각한다.

DPA4099는 그것을 사용할 수 있는 환경에서만 사용하는게 좋다고 생각한다.

모니터링 헤드폰

보컬 , 악기 녹음시, MR 이나, 헤드폰으로 들리는 다른 악기 소리가 마이크로 새어 들어가지 않도록 차폐가 되도록 제작된 헤드폰(보통 closed 헤드폰)

레퍼런스 헤드폰

음악을 재생할때 최대한 평탄한 주파수로 재생하고, 원래의 소리를 최대한 왜곡 없이 원음으로 들려주도록 제작된 헤드폰(보통 open 헤드폰)

모니터링 헤드폰 경우 차폐율이 중요하고, 작은 헤드폰 출력에도 큰 소리를 내어주는 능력이 중요하기 때문에, 헤드폰 임피던스를 작게 만드는편이다. 반면에 레퍼런스 헤드폰의 경우, 최대한 원음 재생을 하는것에 포인트가 맞춰져 있기때문에, 다소 헤드폰의 임피던스가 높을 수 있고, 따라서 고 임피던스 헤드폰 구동을 해줄 수 있는 헤드폰 앰프가 필요할 수 있다.

모니터링 헤드폰의 경우에는 헤드폰에서 들리는 소리가 마이크로 들어가면 안되기 떄문에 Closed 로 만들지만 Closed 의 경우 내부에서 공간이 생성되고, 이에 따라 소리의 특정 주파수 대역에 변화나 왜곡이 생성 되기 때문에, 레퍼런스 헤드폰의 경우에는 Closed 로 제작하지 않고 Open 형 헤드폰으로 주로 만들어진다.

믹싱/마스터링용 헤드폰?

때로, “모니터링” 이라는 말 때문에, 스튜디오 모니터 스피커와 혼동되어, 믹싱이나 마스터링을 할때 사용하는 헤드폰을 모니터링 헤드폰이라고 말하는 경우가 종종 있는데 , 이것은 모니터링 헤드폰의 사용 목적과는 사실 크게 다르다고 볼 수 있다. 실제로 음원의 믹싱/ 마스터링을 위해서는 “레퍼런스 헤드폰” 을 사용하는것이 더 유리하다. (원음에 가깝기 때문)

모니터링 헤드폰은 사실 공연장 등에서 사용하는 “스테이지 모니터링 스피커”에서 말하는 “모니터링’ 의 목적에 더욱 가깝다.

얼마전 밴드 녹음이 있었는데, 평소처럼 소니 헤드폰 7510으로 모니터링을 연주자들에게 주었습니다.

문제는 베이스 연주자의 모니터링 불평이었습니다. 드럼이나 피아노 연주자는 크게 불평이 없었는데, 베이스 연주자가 유독 베이스 소리가 안들린다며 불평했고, 저는 모니터링 콘솔에서 베이스 연주자 CUE 버스 쪽으로 베이스 페이더를 높혀주었지만, 베이스 연주자는 계속 아쉬워 했습니다.

녹음 세션이 끝난후 곰곰히 뭐가 문제일까 음악을 틀고 스스로 그 CUE 헤드폰으로 들어보기도하고, 저는 잘들리기만 하는것….음..

근데 세상은 제가 아닌사람도 많고 , 스팩트럼이 항상 넓은게 세상입니다. 연주자가 헤드폰 모니터링에 익숙하지 않을수도 있고, 사람마다 청력은 다 다르니까요.

그래서 아마, 혹시 헤드폰 모니터링에 익숙하지 않은게 아닐까 하는 생각이 들더군요. 예상외로 많은 사람들이 클로즈드 헤드폰 소리에 익숙하지 않습니다.

게다가 저의 모니터링 큐 버스는 전부 모노 버스가 아닌 스테레오 버스입니다. 예전의 아날로그 콘솔들은 Aux send 버스가 전부 모노 였지만, 요즘 의 DSP 엔진들은 스테레오 버스 로 만들어져 있습니다.

또, 녹음실에서는 헤드폰으로 듣는소리가 마이크로 들어가면 안되기 때문에, 녹음시 모니터링용도로 클로즈드 헤드폰(밀폐형 헤드폰) 또는 IEM(인이어 모니터) 를 사용하게 됩니다. 이러한 소리는 센터 이미지가 형성되지 않기 때문에 (좌우의 소리가 섞이는 메카니즘이 없습니다.) 소리의 밸런스나 킥, 보컬, 베이스 음의 크기에 대한 정보를 알기가 어렵습니다. 소리의 밸런스를 알기 위해서는 센터 이미지가 결정적인 역할을 하기 때문입니다.

그래서 시중에 보면 헤드폰 앰프중에 강제로 센터 이미지를 만들어내서 헤드폰 아웃 출력을 해주는 기기도 있습니다.

SPL 의 포니터 같은 헤드폰 앰프를 보면 Crossfeed 라는 기능이 있어서 좌우의 소리를 강제로 크로스피드해서 클로즈드 헤드폰으로도 센터 이미지를 들을수 있도록 해주는 기능이 있습니다. 워낙 헤드폰 앰프 치고는 가격이 비싸기 때문에, 대체 이게 무슨 소용인가 싶었는데, 왠지 이제 이런것을 쓰는 이유를 알것 같습니다.

그래서 생각난 플러그인이 바로 NX 플러그인입니다.

Waves NX 를 해당 CUE 버스에 걸어주고, 헤드폰 EQ 를 Sony-7506 에 맞췄습니다. (제가 쓰는 헤드폰은 7510 이지만 플러그인안에 프리셋이 아직 없습니다.) Waves 의 Soundgrid 시스탬을 사용하고 있기때문에, 실시간으로 플러그인을 걸수 있습니다.

그러고서 , 다시 해당 CUE 버스의 헤드폰으로 음악을 들어보니, 한결 베이스 음이 잘들리고, 소리의 센터 이미지들이 잘들리게 되었습니다. 밸런스도 알수있었습니다. 플러그인을 Bypass 해보면서 체크해보는데 확실히 NX 가 걸린쪽이 연주하기 편하고 모니터링이 쉬웠습니다.

앞으로 모니터링에 대해서 힘듬을 토로하는 연주자의 모니터 버스에는 NX 를 걸고 들려줘야겠습니다.

이미 해외에서는 인이어 모니터의 이러한 문제점들 때문에, Klang 같은 회사에서 이를 적용한 퍼스널 모니터링 믹서 제품도 나와있습니다. 워낙 가격이 비싸서 얼마나 활용될지는 모르겠습니다만..

라이브 현장에서는 모노버스(스테이지 모니터 스피커) -> 스테레오 버스(IEM, 퍼스널 모니터 믹서) 로 점차 바뀌면서 이런것으로 또 새로운 영역이 개척되고 있는것 같습니다.

저도 앞으로 좀더 사용해보고 , 적용시켜볼 생각입니다.

추가내용) DSP 점유율이 아쉬울때는, 차라리 스테레오 버스의 L R 패닝을 각기 조절할 수 있는 점을 이용해서, 아래 그림처럼 해당 모니터 버스의 스테레오 이미지를 좁혀서 사용하는 방법도 있습니다.