(어떠한 지원도 없이 제가 직접 구매사용한 제품입니다.)

TASCAM 의 16X08 오디오 인터페이스에 Waves Soundgrid DSP server 를 붙여서

waves 의 플러그인들을 DSP 로 돌려보려고 합니다.

- SG connect 로 사운드 그리드에 Tascam 16X08 을 붙여봅니다.

사운드 그리드 드라이버 컨트롤 패널에서 SG connect 를 활성화 시켜줍니다.

2.사운드 그리드 스튜디오에서 하드웨어 I/O 디바이스에 이제 Local device 로 Sg connect 에서 활성화한 Tascam 16X08 을 등록하여 사용할 수 있습니다.

입출력 Patch 도 자유자재로 됩니다. 마치 Soundgrid 의 I/O 인것 처럼 패치 할수 있습니다.

3. 사용하는 DAW 의 오디오 인터페이스 드라이버를 Soundgrid 를 잡아줍니다.

Sg connect 에서 오디오 인터페이스를 활성화 하면, OS 나 DAW 가 사용할수 없기 떄문에, Soundgrid Studio 에서 해당 오디오인터페이스를 가지고 간후, 그 Soundgrid studio 를DAW 나 OS 에서 잡아서 쓴다고 이해하면 될것 같습니다.

6. Studio rack (DSP) 를 이용하여, Soundgrid DSP 로 Waves 플러그인을 사용한다.

일반 ASIO 를 지원하는 아무 오디오 인터페이스와 Soundgrid DSP server 를 같이 사용할수 있는 SG connect 의 기능으로, CPU 자원을 안쓰고 DSP 로 waves 플러그인을 돌릴 수 있습니다.

또한 오히려 Soundgrid emotion st 의 Patch 시스탬이나 mixer 시스탬을 활용할수 있어서,

기존의 오디오인터페이스를 더 확장하여 사용할 수도 있습니다.

하지만 헤당 오디오 인터페이스의 ASIO latecny 만큼이 추가되어, 실시간 으로 이팩터를 걸고 처리하는것은 무리가 있고, 믹싱/마스터링 정도에 사용할 수 있을것 같습니다.

(실시간으로 이팩팅을 하고 소리를 모니터링하려면 Digigrid 같은 soundgrid 전용 I/O 를 사용하면 됩니다.)

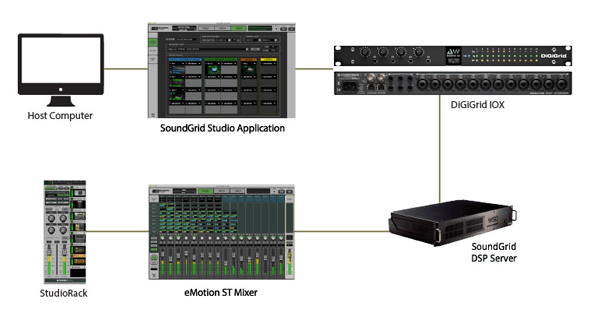

기존의 Soundgrid 호환 I/O 와 일반 ASIO 오디오 인터페이스를 혼용하는 다음과 같은 셋팅도 됩니다.

(이렇게 하이브리드 셋팅을 하는경우, TASCAM 16X08 의 input latency :2ms, ouput latency :8ms 라고 할때, tascam 의 input 을 digigrid output 으로 출력하는 Route 의 경우, Input latency 인 2ms 만 추가 되게 됩니다.왜냐하면, 디지그리드 아웃풋은 Soundgrid 호환이라 zero latency 이기 때문에, input 에 해당하는 latency 만 추가 되게 되는것 같습니다. 어떤 루우팅,패치 도, 해당 input, 또는 output 에 해당하는 latency”만” 추가 되네요)

P.s 많은 분들이 UAD 와 비교를 하시는것 같아 장단점을 말씀드리자면, UAD 에 비해서 레이턴시가 현저하게 짧습니다. 그리고 64bit float 프로세싱(waves 플러그인이 원래 CPU 기반이기 때문이죠) 이기 때문에, 트랜지언트나 다이내믹 계열, 그리고 EQ 계열이 정말 좋습니다. UAD 는 32bit float 기반이고 몇몇 플러그인에서 192khz 강제 오버 샘플링을 지원해서 , 그런부분에 장점이 있는 반면 waves 의 경우에는 플러그인 프로세싱은 거의 대부분 96khz 까지 지원이라서 살짝 아쉬운 부분은 있습니다. 하지만 오디오 가청 주파수 대역폭을 생각해보면 96khz 도 차고 넘치는 실정이라 크게 단점은 아닌것 같습니다. 높은 샘플링 레이트로 이득을 볼수있는 플러그인 계열은 시간에 관계된, 리버브 , 나 딜레이 계열입니다. 하지만, waves 의 abbeyroad plate 리버브 나 IR 리버브도 정말 좋은 리버브이기 때문에, 크게 걱정은 없을것 같네요.